Antonella LEONCINI BARTOLI

Stratégies de promotion des technologies innovantes : analyse interlinguistique de la Proposition de Règlement sur l’Intelligence Artificielle

Antonella Leoncini Bartoli

Sapienza Università di Roma

antonella.leoncinibartoli@uniroma1.it

Abstract

This study aims at analysing the Proposal for a Regulation of the European Parliament and of the Council on Artificial Intelligence (AI) through various enunciation strategies across the French-English and Italian versions. We will first present its motives and objectives, then analyse the enunciation strategies involved in reconciling the need for innovations aimed at promoting the flourishing of AI with the human centered approach. Finally identifying the linguistic markers of the shift from increasing automation to the autonomization of these systems.

Résumé

L’objet de cette étude est la Proposition de Règlement du Parlement européen et du Conseil sur l’intelligence artificielle (IA) analysée à travers quelques stratégies d’énonciation dans la version en français à laquelle les versions en anglais et en italien seront comparées afin d’en relever les “effets de sens”. Nous en présenterons tout d’abord intentions et objectifs, puis nous analyserons les stratégies énonciatives de la conciliation entre innovation favorable à l’épanouissement des systèmes d’IA et exigence de préservation de l’humain. Enfin nous relèverons quelques marques linguistiques du passage de leur automatisation croissante à leur autonomisation.

Introduction

Les défis posés ces dernières années par la performance et l’évolution accélérée des technologies numériques – toujours plus efficaces et compétitives – jusqu’à la mise sur le marché fin 2022 de ChatGPT et la conséquente démocratisation des systèmes d’intelligence artificielle générative, nous ont conduite à porter notre attention sur la Proposition[1] de Règlement du Parlement européen et du Conseil établissant des règles harmonisées concernant l’intelligence artificielle (législation sur l’intelligence artificielle) et modifiant certains actes législatifs de l’Union COM (2021) 206 final. Cet acte juridique a suscité une ample résonance dans la presse mondiale. Les pages d’information sur les objectifs et les progrès de l’Union en matière de technologies numériques, publiées sous le titre Bâtir l’avenir numérique de l’Europe[2] et destinées au grand public, seront également prises en considération. Elles complèteront notre corpus et éclaireront, au moyen d’un discours de vulgarisation, libéré des contraintes de la langue du droit[3] et du discours d’expert, donc d’accès et d’usage plus large et immédiat, quelques énoncés implicites dans le Règlement.

Nous procéderons à une analyse qualitative de quelques choix lexicaux et stratégies d’énonciation dans la version en français principalement, à laquelle les versions officielles en anglais et en italien seront comparées en présence de variations significatives ayant des « effets de sens » (RAUS 2022 : 67) sur le message. L’intention exprimée par la Proposition est celle de promouvoir l’innovation technologique tout en la réglementant afin de protéger les utilisateurs des risques potentiels et évolutifs des systèmes d’intelligence artificielle. Notre objectif est de rendre manifeste dans la langue l’exigence pressante de favoriser le développement et la mise à niveau technologiques et numériques des entreprises européennes, nécessaires à consolider l’attractivité économique aussi bien que la position politique et diplomatique de l’Union au sein du contexte mondial actuel ainsi que de nous interroger – au regard d’une autonomisation croissante de ces technologies – sur l’exigence et l’urgence de leur gestion stratégique sur le plan géopolitique.

S’agissant d’un contexte institutionnel multilingue et d’une thématique pointue aussi bien que critique et désormais omniprésente, aux multiples implications et retombées juridiques mais également économiques, sociales, politiques voire éthiques interdépendantes, notre réflexion se situera à la croisée de différents apports théoriques et cadres méthodologiques. Tout d’abord ceux traitant de la spécificité du vocabulaire et de la langue juridique (CORNU 2005, 2018 ; CAVAGNOLI 2013 ; LERAT 2017 ; PUIGELIER 2020) et de leur traduction (GALLAS 1999 ; GALLO 1999 ; WAGNER et al. 2002 ; COSMAI 2007 ; BOCQUET 2008), analysés au sein d’un cadre institutionnel suivant les approches de l’analyse de discours, de la rhétorique et de la pragmatique dans leur dimension argumentative et de construction d’un dit consensuel (CHARAUDEAU, MAINGUENEAU 2002 ; VILLAR 2006 ; KRIEG-PLANQUE 2013). Puis quelques études centrées sur les questionnements inhérents au domaine de l’intelligence artificielle (LE CROSNIER 2014 ; FORYCIARZ et al. 2020 ; ZUBOFF 2020 ; BYK, PIANA 2021 ; COELHO 2023 ; MHALLA 2024) notamment dans ses relations avec la(les) langue(s) appelée(s) à la décrire, la réglementer et à partager et divulguer ses avancées et ses limites (RAUS 2022, 2023 ; BENANTI 2024).

Après avoir donc cerné les motifs et les intentions exposés dans cette Proposition ainsi que les objectifs ciblés par les énonciateurs, nous analyserons les stratégies linguistiques mises en œuvre en vue d’obtenir un consensus favorable à l’IA – légitimation et captation – puis les modalités d’atténuation du dire – euphémismes, langue neutre – afin de parvenir à concilier innovation visant le renforcement des systèmes d’IA et impératif de préservation de l’humain. Enfin par la confrontation entre les différentes versions linguistiques et entre langue juridique et langue générale, nous étudierons les effets de sens et les actes de langage inscrivant dans la(les) langue(s) le passage de l’automatisation croissante de ces systèmes à leur autonomisation génératrice d’inquiétude et d’incertitude.

1. Motifs et objectifs de la Proposition: une nécessité prioritairement économique et politique réalisée au moyen d’un cadre juridique contraignant

La Proposition s’ouvre sur un intéressant « Exposé des motifs / Explanatory memorandum / Relazione », comptant 18 à 19 pages suivant les versions linguistiques et subdivisé en cinq parties, visant à contextualiser et à motiver les choix accomplis par l’Union en matière d’intelligence artificielle (dorénavant abrégée en IA)[4] :

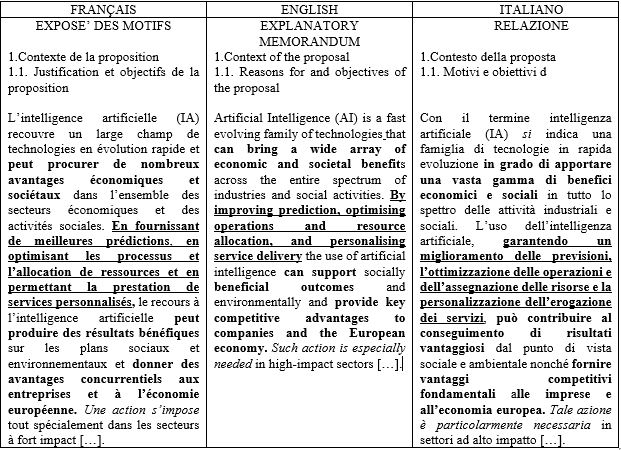

Tableau 1 : explication des avantages apportés par l’IA (Exposé 1.1.)

Dès le premier paragraphe de l’Exposé, l’IA est brièvement caractérisée par son ensemble étendu de technologies et par sa rapidité d’évolution tout en étant simultanément valorisée par ses avantages (RAUS 2022 : 65, 69-72). Cette explication destinée à un public large et diversifié sera précisée dans la définition énoncée dans le dispositif de l’acte à l’article 3 identifiant la complexité des divers systèmes évolutifs qui la composent. L’énumération des apports bénéfiques et utilitaires de l’IA pour l’Europe dans les domaines économique et commercial, social et environnemental introduite par le verbe « pouvoir/to can/apportare-potere » et par l’anaphore des verbes conjugués au gérondif – « en fournissant », « en optimisant », « en permettant » – construit un réseau sémantique suggérant l’efficacité et l’excellence. Ces valeurs sont confirmées par l’emploi d’adjectifs laudatifs en particulier dans les versions en anglais et en italien : « nombreux avantages », « résultats bénéfiques », « avantages concurrentiels »/« a wide array of […] benefits », « beneficial outcomes », « key competitive advantages »/« vasta gamma di benefici », « risultati vantaggiosi », « vantaggi competitivi fondamentali ». Cette dernière version va jusqu’à garantir (« garantendo ») certains de ses bienfaits alors que les deux autres versions sont plus prudentes sur ses effets (« en fournissant/ by improving »). Cette stratégie de captation visant à « […] persuader le partenaire de l’échange communicatif de telle sorte que celui-ci finisse par entrer dans l’univers de pensée qui sous-tend l’acte de communication et partage ainsi l’intentionnalité, les valeurs et les émotions dont il est porteur » (CHARAUDEAU, MAINGUENEAU 2002 : 92-93) caractérise le discours promotionnel avec son insistance et sa redondance (formes du gérondif citées supra) que nous retrouvons ici. Le sujet de l’énonciation implicite dans les trois versions de ce passage par la référence à l’économie européenne est présent dans la seule version en italien dans la formulation impersonnelle du pronom « si » : « Con il termine intelligenza artificiale si indica » afin de construire progressivement dans le discours un consensus favorable au développement généralisé des technologies d’IA. Ces technologies réglementées au moyen de l’acte juridique incarné par ce Règlement qui par son existence même réalise ce consensus normatif. L’énonciateur est nommé plus loin en la personne de la Présidente de l’Union européenne dont l’engagement politique en faveur d’« Une Union plus ambitieuse »[5] prévoyait que la Commission présente « une proposition législative en vue de l’adoption d’une approche européenne coordonnée relative aux implications humaines et éthiques de l’IA ».

Le premier objectif de l’UE est donc à la fois économique et politique : développer et favoriser l’emploi de ces technologies avancées dans tous les secteurs industriels en respectant les valeurs et les droits et principes fondamentaux à la base de l’Union (EXPOSÉ : 3.3 : 10-11). Cette action d’investissement est affirmée comme une nécessité « needed/necessaria » renforcée par l’emploi des adverbes dans les trois versions « tout spécialement/especially/particolarmente » alors qu’elle revêt un caractère d’obligation et d’imposition formulée à la forme impersonnelle selon le mode performatif dans la version en français: « une action s’impose tout spécialement dans les secteurs à fort impact/Such action is especially needed in high-impact sectors/Tale azione è particolarmente necessaria in settori ad alto impatto » et constitue une stratégie de légitimation confirmée par le principe de subsidiarité consacré à l’article 5 du TUE et rappelé ici au considérant (87).

Le paragraphe de clôture de cet Exposé rappelle la primauté de ce premier objectif destiné à « soutenir l’innovation […] et à soutenir les petites et moyennes entreprises (PME) et les start-up » (Exposé : 1.1), ce soutien comportant une réduction de « la charge réglementaire » et des coûts de commercialisation :

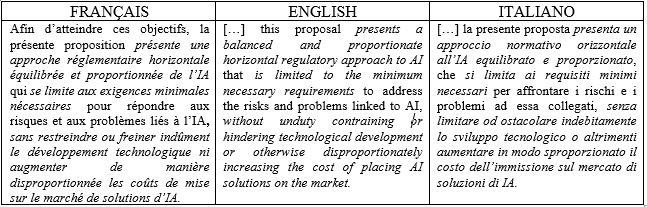

Tableau 2 : approche réglementaire de l’IA favorisant les entreprises européennes (Exposé 1.1.)

L’intention de favoriser les entreprises européennes est explicitement soulignée ici par la phrase à la forme négative « sans…ni » niant les verbes ‘répressifs’ – « restreindre, freiner/contraining, hindering/ostacolare » – et suggérant des modalités d’évaluation négatives – « indûment », « disproportionnée » – à l’égard de toute restriction au développement de l’IA. L’autocélébration des énonciateurs dans la formule « approche réglementaire horizontale équilibrée et proportionnée » se révèle nécessaire à capter la bienveillance d’une partie des destinataires intéressés au développement des PME et des jeunes pousses du secteur de l’IA et à les rassurer.[6] La réduction de ces charges ainsi que les financements attribués par l’Union (Proposition, Fiche financière législative, 1., 2., 3.) visent à favoriser un développement technologique harmonisé, coordonné sous son égide.

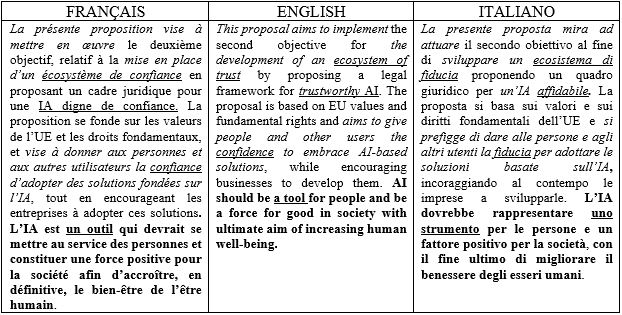

Le deuxième objectif, indissociable du précédent et illustré dans le tableau suivant, est celui de s’assurer la confiance des « personnes » et des « autres utilisateurs » européens de l’IA ainsi que des entrepreneurs des États membres afin qu’ils soient disposés à investir dans ces systèmes :

Tableau 3 : la mise en place d’une IA européenne digne de confiance (Exposé 1.1.)

Le syntagme métaphorique « écosystème de confiance » utilisant un premier terme désormais à la mode et rendu familier par la presse et par le discours économique (RAUS 2022 : 76 ; 2023 : 70, 74), politique et institutionnel[7] entend véhiculer ici une idée de contexte familier (oikos = maison, environnement) et naturel par référence à l’environnement biologique et se réfère aux interrelations et à la collaboration entre les éléments constitutifs d’un même ‘système’ qui légitime la priorité accordée aux entreprises appelées à « adopter ces solutions ». À ce syntagme fait pendant le syntagme « IA digne de confiance », qui dans la version française personnifie l’IA à la différence des deux autres versions « trustworthy AI / IA affidabile » en lui attribuant des qualités proprement humaines telles la dignité et la confiance – ce dernier terme est répété trois fois dans ce bref passage sur 16 occurrences au total. Ces deux syntagmes fonctionnent comme des formules propices employées « à un moment et dans un espace public donnés » qui cristallisent et contribuent à construire les enjeux politiques, sociaux et éthiques de l’Union au sujet de l’IA (KRIEG-PLANQUE 2013 : 110). Le « cadre juridique » évoqué ici légitime donc la proposition d’une réglementation harmonisée, cohérente et uniforme, orientée à éviter « la fragmentation du marché » nuisible non seulement à la sécurité des technologies de l’IA et préjudiciable à la sécurité juridique au sein de l’Union mais également aux relations commerciales à l’intérieur et à l’extérieur de celle-ci. Le Règlement, acte contraignant directement applicable dans tous les États membres (GUIDE 2015 : 2.2.1.), destiné à coordonner les différentes législations nationales européennes relativement à la réduction des charges administratives et financières et à la gestion normative et budgétaire, constitue l’instrument de gouvernance de l’IA.

Ambitionner à un positionnement mondial solide basé sur le pouvoir économique conquis au moyen des technologies numériques avancées est donc une exigence urgente et incontournable pour l’Europe. Il s’agit, par-là, de la reconquête d’une position d’autorité dans le cadre géopolitique actuel, mouvant et hautement concurrentiel dans lequel l’Europe est à l’étroit en matière d’investissements en IA, serrée entre les puissances mondiales connectées comme la Chine et les États-Unis :

Les rivalités se cristallisent autour d’une compétition technologique à couteaux tirés entre Chine et États-Unis. Intelligence artificielle civile, reconquête de l’espace, climate tech, chiffrements quantiques et post-quantiques, armes autonomes et systèmes d’intelligence artificielle à usages militaires… La compétition se fait à tous les niveaux, à coups de pressions, de coercition, de coopération, d’alliances nouvelles, de menaces. En étau entre la Chine et les États-Unis, l’Europe, l’Inde, la Corée du Sud et d’autres encore aspirent à « en être », se positionnent pour jouer leur partition dans la recomposition du monde. (MHALLA 2024 : 16)

Ce renforcement de la leadership stratégique par l’adoption d’un cadre législatif coordonné relève donc bien du domaine politique : « La présente proposition met en oeuvre l’engagement politique pris par la présidente […] / This proposal delivers on the political committment by President […] / Con la presente proposta si tiene fede all’impegno politico della Presidente […] » et les termes « engagement / committment / impegno » ainsi que le verbe « tiene fede » soulignent l’intentionnalité symbolique de cet acte.

2. Concilier la promotion des systèmes d’IA et l’exigence de préservation de l’humain : un pari normatif

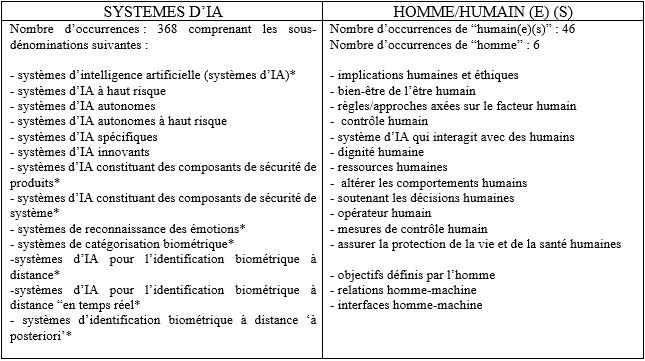

L’aspiration de l’Union européenne à réaffirmer, sur le plan mondial, son modèle humano-centré porteur de valeurs universelles : morales, sociales et éthiques est explicitement déclaré dès la COM (2018) 795 Un plan coordonné dans le domaine de l’intelligence artificielle. Paladine emblématique des droits fondamentaux et des principes éthiques elle déclare que l’optique privilégiée pour réglementer les technologies avancées et les systèmes d’IA existants, émergents et à venir est « axée sur le facteur humain » (EXPOSÉ : 1.1.) privilégiant, par cohérence, une approche juridique « fondée sur les risques » et en particulier sur les systèmes à haut risque qui ont « une incidence préjudiciable significative sur la santé, la sécurité et les droits fondamentaux des citoyens dans l’Union » (27). Prédisposer un cadre normatif clair, mais également sûr, fiable et éthique (EXPOSÉ : 1.1.) qui soit également souple pour s’adapter à l’évolution de ces technologies innovantes, à l’apprentissage continu des IA génératives ainsi qu’à affronter les risques potentiels conséquents remplit la double finalité de construire une « IA digne de confiance » d’une part et d’assumer, de l’autre, le rôle de chef de file et de référence mondiale en matière de réglementation de ces technologies dans la lignée de la tradition prestigieuse de culture juridique européenne.[8] Afin de rendre compte des différentes typologies de ces systèmes se basant sur une infrastructure TIC sous-jacente (51), nous avons donc décidé de relever les occurrences du syntagme-clé objet de l’acte, « systèmes d’IA » et ses composés et de les mettre en parallèle avec les mots-clés « homme/humain »[9] cités dans leur cotexte d’emploi ainsi que dans leurs interdépendances (ex. homme-machine). Nous en présentons les résultats sous forme de tableau :

Tableau 4 : occurrences du syntagme-clé « systèmes d’IA » avec ses composés et des mots-clés « homme/humain »

L’article 3 (Définitions) du Dispositif présente la définition suivante de

« système d’intelligence artificielle (système d’IA) : un logiciel qui est développé au moyen d’une ou plusieurs techniques et approches énumérées à l’annexe I et qui peut, pour un ensemble donné d’objectifs définis par l’homme, générer des résultats tels que des contenus, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels il interagit ».

Elle est ensuite complétée par une multiplicité de dénominations relevées au fil de l’acte dont seulement un nombre réduit d’entre elles, signalées dans le tableau ci-dessus par un astérisque, sont définies à l’article 3 pour désigner des référents diversifiés selon leur(s) finalité(s) et contexte(s) d’utilisation et de destination. Ce foisonnement de dénominations rend ainsi difficile l’appréhension de l’objet dont la nature reste floue, surtout pour un lecteur/utilisateur non expert.[10] D’ailleurs le verbe « influencer » – « influençant/influencing/che influenzano » – employé pour définir l’impact de ces technologies sur les environnements en interaction constitue un euphémisme compte tenu de l’irréversibilité de certaines actions potentielles de ces technologies (Art. 3 Définitions (44) « incident grave »)[11]. Cette généralisation intentionnelle qui regroupe techniques et approches diverses sous l’appellation du syntagme-clé « système d’IA » est justifiée dans l’Exposé : « La définition d’un système d’IA dans le cadre juridique a été pensée pour être aussi neutre que possible sur le plan technologique et pour résister à l’épreuve du temps, en tenant compte de l’évolution rapide des technologies et du marché de l’IA » (5.2.1.). À cette neutralité technologique semble correspondre une intention de neutralité linguistique visant à atténuer un impact trop marqué dans le choix des termes et recourant au procédé de l’euphémisation caractéristique de la langue des organisations internationales (COSMAI 2007 : 175-181, VILLAR 2006 : 12, 216-217). Afin d’identifier plus précisément les référents humains des environnements en interaction avec l’IA, nous avons voulu affiner notre recherche et compléter ce second champ-clé – « homme/humain » – en relevant les occurrences du terme « vulnérabilité(s) » et de sa forme adjectivale « vulnérable(s) » – « vulnerability/vulnerable » ; « vulnerabilità/vulnerabile/i ».

En effet la présence du terme « vulnérabilité » qui « innerve l’ensemble du droit des personnes protégées » (Guinchard, Debard 2021-2022 : 1095) constitue dans le discours une indication prédictive essentielle sur les victimes potentielles des risques[12] éventuellement causés par les systèmes d’IA :

En droit, état d’une personne qui, en raison de certaines circonstances, ne peut, en droit ou en fait, jouir de l’autonomie suffisante pour exercer ses libertés et droits fondamentaux, ce qui justifie, en retour, une protection accrue des pouvoirs publics. Sont ainsi considérées comme vulnérables les personnes dont les droits et libertés sont menacées ou altérées du fait de leur situation pathologique ou de handicap, de leur âge ou de leurs conditions économiques d’existence. [Droit pénal]. Circonstance aggravante de nombreuses infractions, tenant au fait que la victime, en raison de son âge, d’une maladie, d’une infirmité, d’une déficience physique ou psychique, d’un état de grossesse, mérite une protection particulière dès lors que cette situation est apparente ou connue de l’auteur des faits (GUINCHARD, DEBARD 2021-2022 : 1095)

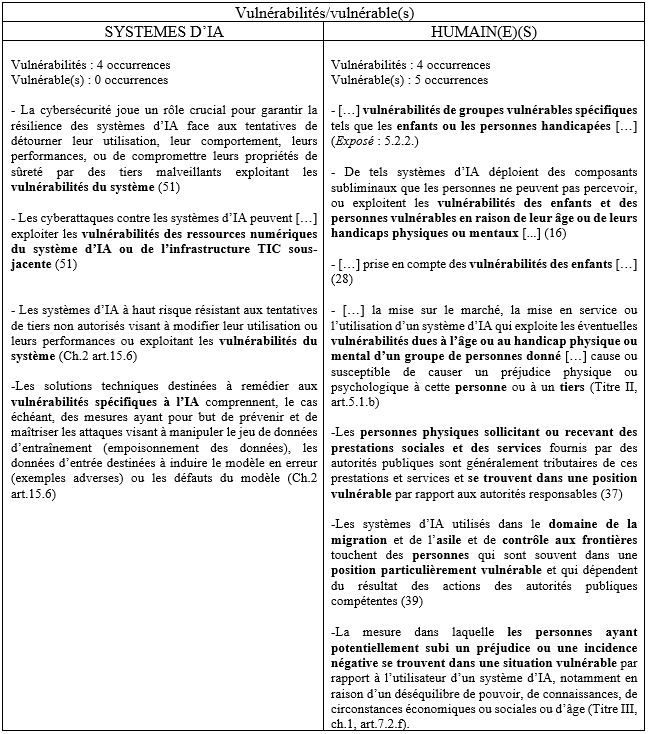

Or, bien que la notion de « vulnérabilité » – attestée dans la Proposition toujours sous sa forme plurielle – résulte définie dans quelques dictionnaires juridiques français qui la recensent en tant que référée à l’être humain (LERAT 2017 : 255 ; CORNU 2018 : 114 ; PUIGELIER 2020 : 1254), nous pouvons également constater son emploi – souligné en gras – relatif aux systèmes d’IA dans le tableau ci-dessous :

Tableau 5 : occurrences des termes « vulnérabilités/vulnérable(s) » dans la Proposition

Bien que le terme « vulnérabilité » autrement que référé à l’humain ne soit pas recensé dans les dictionnaires juridiques consultés, il est bien défini dans les dictionnaires linguistiques généralistes en ligne comme « [inanimé concret] qui peut être attaqué, atteint facilement » (TLFi) voire exemplifié : « vulnérabilité des systèmes » (LE PETIT ROBERT). La forme substantivale – dont le nombre d’occurrences (4) est le même pour les deux référents – est toujours employée au pluriel et est rapportée aussi bien aux êtres humains qu’aux technologies de l’IA, objet de la réglementation. Ceci nous semble notable dans ce cadre normatif et ouvre à des questionnements juridiques et éthiques dont témoignent les choix linguistiques : concept juridique aux référents multiples ici, son double emploi référé aux personnes physiques et à des objets concrets (logiciel) ou abstraits (contenus, données, ressources) pourrait-il affaiblir la notion ? Ne pourrait-on pas réserver ce terme en droit uniquement référé à la personne ? Sous sa forme adjectivale il est employé aussi bien au singulier qu’au pluriel et se réfère uniquement aux êtres humains – personne(s) ou groupes vulnérables, position ou situation vulnérable – dans deux cas sur cinq il se trouve en corrélation avec la forme nominale « vulnérabilité » (exemples 1 et 2) marquant, par cette répétition conceptuelle, le lien sémantique qui constitue le réseau de cohésion propre à la langue juridique (LEONCINI BARTOLI 2016 : 66). Les causes de cette vulnérabilité sont précisées : âge, handicaps physiques ou mentaux, nécessité de prestations sociales et de services, situations de migrants ou de demandeurs d’asile, déséquilibre de pouvoir et de connaissances – ainsi que les conditions de dépendance par rapport à « l’utilisateur d’un système d’IA », aux « autorités responsables / autorités publiques compétentes » (Titre III, ch.7.2.g).

Les principaux domaines de référence de ces « vulnérabilités » sont nombreux et diversifiés : la santé (physique, psychique), la sécurité, les droits fondamentaux, la migration, la culture (connaissances), la politique (pouvoir). Pour ce qui est des systèmes d’IA, les atteintes ou cyberattaques par des « tiers malveillants / non autorisés » portent sur leurs propriétés, leurs ressources / données, leurs défauts, leurs performances et leur destination et nous interpellent sur les choix effectués en amont de leur conception.[13]

Dans les exemples cités, les verbes utilisés rendent compte à la fois de la vulnérabilité de ces systèmes qui peuvent être : détournés, compromis, exploités, modifiés, manipulés, et de leur possibilité de porter atteinte à la personne : toucher, exploiter, déployer des composants subliminaux, causer un préjudice. Ces verbes témoignent, comme pour les êtres humains d’ailleurs, de leur double positionnement en tant qu’agent ou victime.

Le lecteur est donc le témoin d’un transfert de propriétés et de caractéristiques distinctives de l’être humain à ces systèmes d’IA (RAUS 2022 : 73), les outils génératifs en particulier, véhiculées à partir de la langue générale et de l’usage généralisé à la langue du droit, au sein d’un acte à valeur contraignante pour les États membres.

3. De l’automatisation à l’autonomisation des systèmes d’IA : l’inscription du pouvoir technologique dans la langue

Nombre d’exemples tirés de l’acte aussi bien que de pages d’information sur l’IA publiées par l’Union illustrent effectivement l’humanisation de ces systèmes dotés d’une « nature numérique » (11) et d’un « comportement » (51), qui font partie d’un écosystème et interagissent avec lui, qui « continuent à apprendre après avoir été mis sur le marché ou mis en service » (78) et sont dotés de capacité d’analyse : « le système collecte, documente et analyse » (art.61.2). Dans le contexte judiciaire, ils effectuent « l’examen automatisé des demandes de visa » (BÂTIR – LOI SUR L’IA) ou « aident à rechercher et à interpréter les faits de la loi » (40) aussi bien qu’ils « prennent des décisions dans des situations très critiques pour la vie, la santé et les biens matériels des personnes » (37). Voilà que « […] la justice prédictive s’avance et il deviendra bientôt possible de juger sans juges, le système judiciaire s’y préparant déjà » (BYK, PIANA, 2021 : 88). De là l’insistance du texte du Règlement à l’égard de la protection des droits fondamentaux. Il s’agit en effet de technologies caractérisées par des « modèles très puissants et percutants » aux « capacités » plurielles et simultanées indénombrables alliées à la rapidité d’exécution : « capables d’effectuer d’innombrables tâches différentes » (BÂTIR – LOI SUR L’IA), dépassant le multitasking humain tant prisé car synonyme d’efficacité et de performativité. La constatation qu’« il est difficile de superviser toutes les capacités / it is difficult to oversee all capabilities / è difficile supervisionare tutte le funzionalità » (BÂTIR-LOI SUR L’IA) témoigne de la différence entre la version italienne dont le terme « funzionalità » est apte à caractériser des objets et des outils technologiques confinés dans leurs fonctions d’exécution et les termes « capacités / capabilities » qui humanisent ces machines-robot jusqu’à leur attribuer des valeurs éthiques telles que la dignité et la fiabilité : une IA « digne de confiance » (18 occurrences). D’ailleurs le sujet qui devrait accomplir l’acte de supervision n’est pas exprimé ici. L’être humain est gommé de l’action mais également de la vérification des opérations de ces systèmes qu’il a créés et qu’il se rend compte ne pas toujours parvenir à maîtriser malgré l’insistance sur leur contrôle clairement exprimée dans le dispositif du Règlement. Tout comme les êtres humains, ces systèmes sont « vulnérables », ils peuvent être induits en « erreur », manipulés à partir de leurs « défauts » ((50) ; ch.2 art.15.6) voire sont imprévisibles, conduisant à leur autonomie partielle : « difficultés posées par l’opacité, la complexité, les biais, le degré relatif d’imprévisibilité et le comportement partiellement autonome de certains systèmes d’IA » (EXPOSÉ : 1.1.).

Or l’automatisation déjà existante se popularise dans l’usage des IA génératives à l’exemple des robots conversationnels (chatbots) conduisant des entretiens d’embauche. Considérés comme faisant partie de l’IA non à haut risque, instruits par des algorithmes, ces chatbots gomment tout ressenti et subjectivité humains (BYK, PIANA 2021 : 82) aboutissant ainsi à une « hypernormalisation »/ standardisation des candidats retenus, non exempte de biais ou de dérives discriminatoires (CESSAC : 10.4.2024). Ou encore la référence à l’application de la robotique – de plus en plus généralisée – dans un domaine à haut risque comme la chirurgie « application d’IA en chirurgie assistée par robot / AI application in robot-assisted surgery / applicazione d’IA in chirurgia robotizzata » (BÂTIR – LOI SUR L’IA). Alors que dans les deux premières versions l’énonciateur précise que la chirurgie est « assistée » par un système d’IA (traduction-calque), la version italienne a déjà déshumanisé la profession par l’étiquette « chirurgia robotizzata ». Ainsi la présence éventuelle ou la supervision d’un opérateur humain est supprimée suivant la constatation exprimée dans le considérant (28) : « robots de plus en plus autonomes, que ce soit dans le secteur de l’industrie manufacturière ou des services de soins et d’aide aux personnes ». En langue générale (BÂTIR L’AVENIR NUMERIQUE DE L’EUROPE) comme en langue juridique l’autonomisation progressive des systèmes d’IA est affirmée à plusieurs reprises : « L’UE continuera d’œuvrer à la mise en place d’un écosystème d’IA à croissance rapide pour les services et les produits innovants intégrant des technologies de l’IA ou les systèmes d’IA autonomes, ce qui se traduira par une plus grande autonomie numérique » (EXPOSÉ : 3.3.), « Les systèmes d’IA peuvent être conçus pour fonctionner à différents niveaux d’autonomie et être utilisés seuls ou en tant que composant d’un produit » (6). Elle résulte ainsi matériellement inscrite dans la langue juridique et se transmet à travers elle. Ce glissement sémantique de l’automatisation progressive à l’autonomisation substitutive de l’humain par des robots, déjà à l’œuvre, se réalise donc au moyen de ces actes de langage en ‘s’incarnant’ dans l’énoncé, dans la « matérialité discursive » de la langue (CHARAUDEAU, MAINGUENEAU 2002 : 19, 365). Les références à l’autonomie accrue de ces systèmes (EXPOSÉ : 1.1., 2.1., 3.3., 3.5., 5.1., 5.2.3., 5.2.6. ; considérants (6), (28), (32) ; art.60) parmi lesquels les « IA autonomes à haut risque » (8 occurrences sur 16) en témoignent et sont entérinés dans ce Règlement. De là l’attention portée au discours afin d’atténuer toute inquiétude à cet égard. Celle-ci est bien présente cependant dans les choix lexicaux de la Proposition « centrée sur les risques » et la répétition constante dans l’acte du syntagme clé « à haut risque » (294 occurrences sur 439 du terme « risque »). S’il est affirmé que le souci majeur de l’Union consiste à protéger légalement les citoyens et les utilisateurs tout en les convaincant des bienfaits de ces systèmes dans une majorité de domaines professionnels – y compris des domaines sensibles comme la santé, la justice, la sûreté – l’emploi diffus du terme « risque » et de ses synonymes ainsi que les interrogations et les discussions suscitées à son sujet se réfèrent explicitement au champ lexical de la peur (BYK, PIANA 2021 : 85-89) « peur de l’incertitude » (BENANTI 2024 : 126). Celle-ci, aussi bien que la stratégie de son atténuation résulte explicitée dans les textes à caractère non normatif de notre corpus : « […] Alors que de nombreux acteurs sur le terrain ont déjà pris des mesures pour atténuer les préoccupations, d’autres mesures urgentes sont nécessaires » (BÂTIR – LE PACTE SUR L’IA), « systèmes d’IA considérés comme une menace évidente […] seront interdits » (BÂTIR – LOI SUR L’IA). Dans l’acte, l’emploi diffus du terme « risque(s) » ou « haut risque » au lieu du terme « menace(s) » (12 occurrences), joue un rôle de ménagement des destinataires (CHARAUDEAU, MAINGUENEAU 2002 : 30). L’intention est la même pour le syntagme « non facilement réversibles / shall not be considered as easily reversible / considerando non facilmente reversibili » (Titre III, chap.2, art.7.1g) référé aux résultats éventuels « ayant une incidence sur la santé ou la sécurité des personnes ». Cette tournure euphémisante qui exploite les lois du discours « nécessaires dans la mesure où le locuteur “n’a pas le droit de donner” certaines informations, en vertu du principe de politesse ou du désir de soustraire à la contradiction le contenu implicité » (CHARAUDEAU, MAINGUENEAU 2002 : 357) est bien une exemplification de la « loi de la litote » où l’adverbe modalisateur a pour fonction d’atténuer l’effet d’irréversibilité. Tel est également le cas des adjectifs et de l’adverbe témoins concrets de « l’emploi euphémisant » (VILLAR 2006 : 35, 216) du langage diplomatique transposé dans le discours institutionnel des énoncés suivants : « […] certains systèmes d’IA créent des risques auxquels nous devons nous attaquer pour éviter les résultats indésirables » (BÂTIR – LOI SUR L’IA), « mesures de réparation efficaces » (Titre III, art.7.1.(h)i), « réduire substantiellement ces risques » (Titre III, art.7.1.(h)ii). Ces formulations indirectes d’actes de langage de la part de l’énonciateur (KRIEG-PLANQUE 2013 : 65-66) visent à préserver le destinataire – et la qualité de leur relation – et à ne pas susciter son anxiété par une expression plus explicite. Le discours de vulgarisation (BÂTIR L’AVENIR NUMERIQUE DE L’EUROPE) – produit par la même instance énonciative du discours juridique- explicite les préoccupations et les menaces inhérentes à l’autonomisation des systèmes d’IA.

Conclusion

Concilier innovation et protection des risques tel est le défi de l’UE dans ce cadre géopolitique « VICA : volatil, incertain, complexe et ambigu » (GERMAIN : 26.1.2024). L’urgence d’une mise à niveau économique et concurrentielle des entreprises européennes par l’intermédiaire d’importants investissements dans les systèmes d’IA destinés à consolider parallèlement sa leadership politique au sein du contexte mondial, passe nécessairement par l’élaboration d’un cadre législatif contraignant et coordonné au niveau de tous les États membres. Un tel cadre centré sur la prise de conscience et la réglementation des risques de ces technologies entend constituer une solution normative stratégique rassurante qui vise à gagner la confiance des destinataires opérateurs économiques / entreprises, organismes publics et citoyens (Exposé : 3.3.) et leur collaboration proactive afin d’empêcher une fragmentation législative à l’intérieur de l’espace européen, dangereuse pour la sécurité et nuisible au développement du marché. La constatation que l’homme est bel et bien dépassé par la rapidité d’évolution et d’action / exécution / production de ces systèmes d’IA est prise en compte et les inquiétudes sur l’autonomisation des systèmes exemplifiées dans les communiqués de Bâtir destinés au grand public. La course du monde à l’innovation au nom de valeurs telles que la concurrence, la productivité et l’excellence, semblent porter préjudice à cette « centration sur l’humain » et à ce qui la caractérise en tant que « roseau pensant », être d’action consciente et responsable, mais également doté d’émotions – un système de reconnaissance des émotions est bien recensé (Titre IV, art.52.2.) ! – et de compétences de communication. Prenant en compte l’ingérence des pouvoirs publics dans la vie privée des citoyens justifiée par des mesures de sécurité (Titre II, Pratiques interdites, art.5,d), Titre III, Systèmes d’IA à haut risque, ch.1, art.7)[14] et dénoncée comme un « capitalisme de surveillance » (ZUBOFF 2020 : 25-30 ; RAUS 2022 : 65, 77, 79), il apparaît impératif d’assurer le respect et la préservation des caractéristiques de l’être humain et de ses droits fondamentaux – comme énoncé dans l’acte – à l’égard de cette technosurveillance. Cette dernière étant sans doute favorisée par une délégation plus ou moins intentionnelle de savoirs et de savoir-faire aux systèmes d’IA, motivée par des raisons souvent non explicitées ou conscientes, qui risque de placer l’être humain dans les conditions d’une dépendance toujours croissante envers les technologies génératives en particulier et par conséquent en situation d’assujettissement ou d’objectivation (RAUS 2023 : 67 ; COELHO 2023 : 229, 252) à leur égard – aussi bien qu’à l’égard de ceux qui les projettent, les produisent et surtout les financent (FORYCIARZ et al. 2020 : 42-44).

Figure de Janus, l’Internet est à la fois support d’un élargissement des moyens offerts aux individus de se coordonner et d’agir dans le monde, et un outil de contrôle social d’une puissance inégalée… Il devient impossible de penser les actions collectives en dehors de son existence. C’est pourquoi nous devons quitter les rivages des mythes autant que ceux de la technophobie pour comprendre les nouveaux rapports de force, les nouvelles formes d’oppression et les nouveaux moyens de libération qui sont rendus possibles par l’existence de ce réseau de communication. (LE CROSNIER 2014 : 32)

Comment comprendre les nouvelles formes de pouvoir qui s’articulent autour de la question technologique et en particulier, autour des Big Tech, géants technologiques hybrides et inclassifiables ? Quelles clés de lecture apposer à des jeux de puissance parfois dangereux, cristallisés autour des nouvelles conflictualités cyber et de néo-guerres augmentées d’intelligence artificielle ? Comment saisir les contours distordus de la souveraineté par cette nouvelle répartition des clés de pouvoir ? Quelles architectures démocratiques inventer, quelles libertés nouvelles imaginer ? (MHALLA 2024 : 11)

À l’instar de la pénétration de la technologie dans la langue, observée dans les textes analysés[15] –toutes deux moyens de puissance, d’influence et de pouvoir – et à partir des deux citations publiées ci-dessus à dix ans d’intervalle – la constatation des avancées hyper-rapides de l’IA et de ses risques potentiels devraient susciter des questionnements légitimes de la part de tout citoyen sur le pouvoir acquis par ces technologies dans leur compénétration croissante avec les sphères politique, militaire et juridique ainsi que sur ses conséquences. Tout lecteur de cette Proposition est tenu à reconnaître l’intention méritoire de « centration sur l’humain », à considérer l’importance des choix technologiques à privilégier mais surtout est impérativement appelé à observer les phénomènes, à réfléchir et à s’interroger sur le projet de société humaine – porteur de quelles valeurs et de quelles finalités éthiques ? – que chacun de nous entend consciemment et responsablement favoriser.

Références bibliographiques

Analyses de la loi sur l’IA. https://artificialintelligenceact.eu/fr/analyses [consulté le 22.3.2024].

BENANTI, Paolo, Le macchine sapienti. Intelligenze artificiali e decisioni umane, Marietti, Bologna, 2024 [2018].

BOCQUET, Claude, La traduction juridique. Fondement et méthode, de Boeck, Bruxelles, 2008.

BYK, Christian, PIANA, Daniela, « L’intelligence artificielle : un “concept flottant” entre apparence de consensus normatif et controverse cachée sur le projet de société », Droit, Santé et Société, n. 3, 2021, p. 76-94. https://www.cairn.info/revue-droit-sante-et-societe-2021-3-page-76.htm

CAVAGNOLI, Stefania, Linguaggio giuridico e lingua di genere: una simbiosi possibile, Edizioni dell’Orso, Alessandria, 2013.

CESSAC, Marjorie, « Des entretiens d’embauche menés par des chatbots : les DRH s’interrogent sur les usages de l’intelligence artificielle », Le Monde, 10 avril 2024.

CHARAUDEAU, Patrick, MAINGUENEAU, Dominique, Dictionnaire d’analyse du discours, Seuil, Paris, 2002, p. 92-93.

COM 2018/795, Un plan coordonné dans le domaine de l’intelligence artificielle.

COM (2024) 28 final, Accroître les jeunes pousses et l’innovation dans le domaine de l’IA digne de confiance.

COELHO, Ophélie, Géopolitique du numérique. L’impérialisme à pas de géants, Les Editions de l’Atelier, Ivry-sur-Seine, 2023.

CORNU, Gérard, Linguistique juridique, Paris, Montchrestien, 2005.

CORNU, Gérard, Vocabulaire juridique, Paris, Quadrige, 12ème édition mise à jour, 2018.

COSMAI, Domenico, Tradurre per l’Unione europea, Milano, Hoepli, 2007.

FORYCIARZ, Agata, LEUFER, Daniel, SZYMIELEWICZ, Kataryna, « Nella scatola nera », L’Internazionale, n. 1346, 21 février 2020, p. 40-47.

GALLAS, Tito, « Coredazione e traduzione giuridica nella legislazione multilingue in particolare quella comunitaria », in ARCAINI, Enrico (dir.), La traduzione. Saggi e documenti, n. 43 (4), Ministero per i Beni Culturali e Ambientali, Roma, 1999, p. 135-147.

GALLO, Giovanni, « Il traduttore e le versioni ufficiali di riferimento », in ARCAINI, Enrico (dir.), La traduzione. Saggi e documenti, n. 43 (4), Ministero per i Beni Culturali e Ambientali, Roma, 1999, p. 159-172.

GERMAIN, Sabine, « Le management court derrière la révolution numérique », Alternatives économiques, 26 janvier 2024.

Guide Pratique Commun du Parlement européen, du Conseil et de la Commission à l’intention des personnes qui contribuent à la rédaction des textes législatifs de l’Union européenne. https://eur-lex.europa.eu/techleg/index.html

GUINCHARD, Thierry, Debard Serge, Lexiques des termes juridiques, Dalloz, Paris, 2021-2022 (29ème éd.)

KRIEG-PLANQUE, Alice, Analyser les discours institutionnels, Armand Colin, Paris, 2013.

LE CROSNIER, Hervé, « Internet et numérique », Hermès, n. 70 (3), p. 25-33.

LEONCINI BARTOLI, Antonella, Guides de rédaction et traduction dans le cadre de l’Union européenne, CISU, Roma, 2016.

LERAT, Pierre, Vocabulaire du juriste débutant. Décrypter le langage juridique, Ellipses, Paris, 2ème édition, 2017.

LE ROBERT informatisé https://dictionnaire.lerobert.com/

MHALLA, Asma, Technopolitique. Comment la technologie fait de nous des soldats, Éditions du Seuil, Paris, 2024.

Orientations politiques de la Commission 2019-2024. https://ec.europa.eu/info/sites/default/files/political-guidelines-next-commission_fr.pdf [consulté le 22.3.2024].

Plan coordonné dans le domaine de l’IA – Révision de 2021 https://digital-strategy.ec.europa.eu//fr/library/coordinated-plan-artificial-intelligence-2021-review [consulté le 22.3.2024].

Programme for Quality Management in Translation, 22 Quality Actions, European Commission, 2009.

PUIGELIER, Catherine (dir.), Dictionnaire juridique, Bruylant, Bruxelles, 3ème édition, 2020.

RAUS, Rachele, « La traduction des discours européens sur l’intelligence artificielle entre effets de sens et ‘capitalisme de surveillance’ », Mots. Les langages du politique, n. 128, 2022, p.65-84.

RAUS, Rachele, « Robotics and artificial intelligence », in CAIMOTTO, M. Cristina, RAUS, Rachele, Lifestyle Politics in Translation. The Shaping and Re-Shaping of Ideological Discourse, Routledge, New York-London, 2023, p. 61-92.

Trésor de la Langue Française Informatisé – ATILF. http://www.atilf.fr/tlfi

VILLAR, Constanze, Le discours diplomatique, L’Harmattan, Paris, 2006.

World News AFP, « Le Parlement européen a, lui, adopté une législation unique au monde pour encadrer les systèmes d’IA comme ChatGPT », 21 mars 2024.

ZUBOFF, Shoshana, L’âge du capitalisme de surveillance, Zulma.fr., 2020.

Corpus

Proposition de Règlement du Parlement européen et du Conseil établissant des règles harmonisées concernant l’intelligence artificielle (législation sur l’intelligence artificielle) et modifiant certains actes législatifs de l’Union COM (2021) 206 final. http://eur-lex-europa.eu [consulté le 22.3.2024].

Bâtir l’avenir numérique de l’Europe/Shaping Europe’s digital future/Plasmare il futuro digitale dell’Europa : Loi sur l’IA ; Pacte sur l’IA ; Proposition de règlement établissant des règles harmonisées dans le domaine de l’intelligence artificielle ; L’approche européenne à l’intelligence artificielle. https://digital-strategy.ec.europa.eu [consultés le 22.3.2024].

[1] Dorénavant abrégée en Proposition. Les actes législatifs modifiés étant les suivants : SEC (2021) 167 final – SWD (2021) 84 final – SWD (2021) 85 final. La Proposition s’ouvre sur un « Exposé des motifs » (abrégé dorénavant en Exposé : 1-19) suivi par le texte du Règlement (20-97) formulé suivant un schéma standard ; GUIDE PRATIQUE COMMUN 2015 : 2.2.1.,7.1. à 7.3., 15.1. à 15.4.) composé d’un Préambule contenant les visas, (89) considérants identifiés par un numéro entre parenthèses ainsi que de la formule solennelle à valeur performative « ont adopté le présent règlement » annonçant le dispositif, la partie normative de l’acte. Celle-ci est dans ce cas subdivisée en XII Titres comportant chapitres et articles et complétée par XIII Annexes. Ce Règlement est entre-temps entré en vigueur le 1er août 2024 d’après le site https://commission.europa.eu.

[2] Shaping Europe’s digital future/Plasmare il futuro digitale dell’Europa, en particulier les pages d’information suivantes : Loi sur l’IA, Pacte sur l’IA, Proposition de règlement établissant des règles harmonisées dans le domaine de l’intelligence artificielle, L’approche européenne à l’intelligence artificielle, accessibles sur le site https://digital-strategy.ec.europa.eu

Un encadré en début de chaque page informe les destinataires que ces textes sont le résultat d’une « traduction automatique fournie par le service eTranslation de la Commission européenne afin d’aider la compréhension ».

[3] « Le langage juridique est technique, principalement par ce qu’il nomme (référent), secondairement par la façon dont il énonce ([…] son vocabulaire, parfois son discours) » (CORNU 2005 : 18 ; cf. également BOCQUET 2008 : 88-97 ; VILLAR 2006 : 62-74, 107-122 ; LEONCINI BARTOLI 2016 : 29-54).

[4] Dans ce premier tableau exposant les trois versions linguistiques en synoptique nous présentons la version en anglais dans la colonne centrale afin de souligner l’influence éventuelle exercée par cette version linguistique sur les deux autres en tant que texte base matrice dans ce domaine d’action en particulier. Dans le cadre des institutions officielles multilingues, la notion de concordance entre les versions linguistiques parallèles se substitue à celle de fidélité entre texte source et texte cible (Programme for Quality Management in Translation, 22 Quality Actions 2009 : introduction). Pour ce qui est de la rédaction complexe du texte-base au sein des institutions européennes consulter, entre autres, Gallo (1999 : 159-172) ; Gallas (1999 : 135-147) ; Cosmai (2007 : 51-57) ; Leoncini Bartoli (2016 : 41-48). Les termes mis en évidence dans les exemples des trois premiers tableaux le sont par nos soins : les énoncés soulignés se réfèrent aux fonctions de l’IA, les énoncés en gras mettent en évidence les choix linguistiques la valorisant, les énoncés en italique signalent la valeur performative de l’énoncé.

[5] Cf. Orientations politiques de la Commission 2019-2024 https://ec.europa.eu/info/sites/default/files/political-guidelines-next-commission_fr.pdf.

[6] Cf. Bâtir – Approche européenne à l’IA et COM (2024) 28 final, Accroître les jeunes pousses et l’innovation dans le domaine de l’IA digne de confiance. Par ailleurs, « Certains pays, dont la France et l’Allemagne, avaient soulevé des points de préoccupation, pris en compte avant la finalisation du texte, selon des diplomates auprès de l’Agence France-Presse. Paris et Berlin étaient notamment soucieux que la législation européenne protège les start-up spécialisées dans l’intelligence artificielle, pour ne pas empêcher l’émergence de futurs “champions européens” du secteur », Le Monde, 2 février 2024.

[7] D’autres occurrences du terme « écosystème » forment les syntagmes suivants : « écosystème d’excellence en matière d’IA » (Bâtir-Proposition de Règlement), « principaux écosystèmes industriels et stratégiques de l’Union » et « grands écosystèmes d’innovation ouverte » (Bâtir- Approche de l’UE en matière d’IA). Dans le cadre de l’UNESCO, par exemple, les syntagmes « écosystème culturel » et « écosystème éducatif » sont utilisés couramment pour désigner l’ensemble des diverses disciplines ou les éléments constitutifs de ces domaines.

[8] Cette intention est attestée dans la presse comme en témoigne l’affirmation suivante : « Le Parlement européen a, lui, adopté une législation unique au monde pour encadrer les systèmes d’IA comme ChatGPT », World News AFP, 21 mars 2024. Les termes en italique dans les citations reportées dans l’article sont soulignés par nos soins. Ce même article fait état d’autres réglementations existantes au niveau supranational telle la Résolution régulant l’IA de l’ONU.

[9] Le mot « homme » est utilisé en langue juridique ici en tant que « masculin générique » ou « masculin non marqué » (CAVAGNOLI 2013 : 53-93) alors que le mot « femme » (3 occurrences) est utilisé dans son acception spécifique.

[10] « La diversité des objets, auxquels il [le concept d’IA] est susceptible de s’appliquer, et leur double appartenance à un univers de réalité scientifique et technique, d’une part, et à un ensemble de perceptions sociales, d’autre part, font de l’IA un “concept flottant”, “à double visageˮ » (BYK, PIANA 2021 : 77). Sur l’opacité de la définition d’IA consulter Foryciarz et al. (2020 : 42-44).

[11] Il s’agit du décès, d’une atteinte grave à la santé, à des biens ou à l’environnement (a), ou d’une perturbation grave et irréversible de la gestion et du fonctionnement d’infrastructures critiques (b).

[12] La notion de « risque » implique celle de responsabilité (BENANTI 2024 : 63-64) aussi bien que la conscience de cette responsabilité, comme précisé dans la définition suivante : « Théorie du risque : théorie suivant laquelle on est responsable du dommage que l’on a causé par son fait, celui de ses préposés ou celui des choses que l’on a sous sa garde, lors même que l’on n’a aucune faute à se reprocher, à raison du risque que, par sa propriété ou son activité, on a fait courir à autrui (le responsable assumant, nonobstant la preuve de son absence de faute, les dommages dont l’origine demeure inconnue) » (CORNU 2018 : 933).

[13] Cf. Foryciarz et al. (2020 : 44-47) : les auteurs invitent chacun de nous à demander plus de transparence sur les choix humains opérés par les propriétaires et les experts des systèmes d’IA, leurs intentions et les objectifs qu’ils visent en amont de leur conception, création et production de ces systèmes. Informations sur la logique à la base de ces technologies : données utilisées, comportement et limites, évaluations de l’impact sur les droits fondamentaux à rendre publiques – surtout lorsque ces choix et les décisions conséquentes ont des retombées essentielles sur la vie des personnes et constituent donc des décisions d’ordre politique. Bien que l’UE ait pris diverses mesures en ce sens parmi lesquelles un dialogue politique ouvert sur l’IA, ait créé l’Alliance européenne sur l’IA (2018), ait publié une évaluation d’impact, un plan coordonné dans le domaine de l’IA (2021) ainsi que plusieurs Communications, ces aspects restent dans certains cas critiques, imprécisés et imprévisibles comme en témoignent les considérants (15) et sq. : qualité des données (38), (44) et « inexactitudes techniques » (33). Dans cette direction BENANTI (2024 : 113-123, 125-154) propose un code éthique et une gouvernance des intelligences artificielles.

[14] Il s’agit de « l’utilisation de systèmes d’identification biométrique à distance ‘en temps réel’ dans des espaces accessibles au public à des fins répressives ».

[15] La compénétration des technologies avec l’humain relevée dans notre troisième partie et la substitution de ce dernier exemplifiée dans le recours à la traduction automatique des pages de BÂTIR en constituent des exemples.

Per citare questo articolo:

Antonella LEONCINI BARTOLI, « Stratégies de promotion des technologies innovantes : analyse interlinguistique de la Proposition de Règlement sur l’Intelligence Artificielle », Repères DoRiF, n. 32 Le droit e(s)t la langue, DoRiF Università, Roma, aprile 2025.

ISSN 2281-3020

![]()

Quest’opera è distribuita con Licenza Creative Commons Attribuzione – Non commerciale – Non opere derivate 3.0 Italia.